Le XC90 Uber accidenté à Tempe (© NTSB)

Le 18 mars dernier, la voiture autonome a fait sa première victime : un Volvo XC90 de la flotte Uber a renversé une piétonne qui traversait la route. Un coup dur pour l’industrie, qui mettait jusqu’alors en avant son exigence de sécurité. Quelles leçons doit-elle tirer de ce drame ? Quel en sera l’effet sur cette technologie ?

C’était un dimanche soir comme un autre dans la ville de Tempe, située en banlieue de Phoenix, la capitale de l’Arizona. Elaine Herzberg, une sans-abri de 49 ans, traversait Mill Avenue en poussant un vélo chargé de sacs pour rejoindre son campement. L’endroit est mal éclairé, inadapté pour les piétons. Au même moment, Rafaela Vasquez, 44 ans, faisait son boulot : celui de superviser le fonctionnement d’un prototype autonome Uber. Ancienne délinquante (elle avait passé trois ans et dix mois en prison pour vol à main armé et faux témoignage), elle avait été libérée en 2005 et avait un casier vierge depuis. Uber n’avait pas hésité à la recruter, la compagnie ayant pour principe de faciliter la réinsertion des anciens détenus.

Un Volvo XC90 de la flotte Uber.

On imagine le côté barbant d’un tel métier : huit heures par jour à surveiller un système qui marche parfaitement… 99,99% du temps. Huit heures par jour à regarder le paysage défiler, à garder les mains à proximité immédiate du volant, à tenter de garder les yeux sur des écrans de contrôle… et à s’ennuyer. Sur la vidéo (qui fait froid dans le dos) publiée par les services de police locaux, on constate que Rafaela Vasquez, à cette heure tardive, accordait davantage d’attention à son smartphone qu’à la surveillance de son véhicule. C’est tragiquement tombé au plus mauvais moment. Peut-on vraiment lui en vouloir ?

Lorsque Vasquez aperçoit Elaine Herzberg, il est déjà trop tard. Lancée à 61 km/h, la voiture percute la piétonne de plein fouet. La victime décédera quelques heures plus tard à l’hôpital. Le choc provoqué par cette nouvelle a immédiatement lancé la polémique sur la voiture autonome : peut-elle tenir ses promesses en matière de sécurité ? Les tests sont-ils fait dans des conditions optimales ? La voiture autonome deviendra-t-elle seulement une réalité ? Il faut donc faire le point.

D’abord, le fait que ce premier accident mortel ait concerné Uber n’a pas vraiment étonné la communauté. La firme, très pressée de mettre sa technologie en service, a visiblement bâclé son développement. Les prototypes Uber se distinguaient déjà par leurs dysfonctionnements récurrents, et des « reprises de contrôle » par leurs superviseurs bien plus fréquentes que chez les rivaux de Waymo (Google) ou Cruise Automation (General Motors). Ensuite, le fait que ce crash ait eu lieu en Arizona, état à la législation particulièrement souple en matière de voitures autonomes (dans le but avoué de concurrencer la Californie sur son propre terrain), n’est pas non plus une surprise.

Une Chevrolet Bolt autonome de Cruise Automation, filiale de General Motors

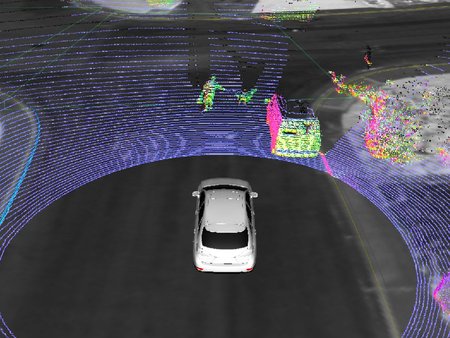

Que s’est-il donc réellement passé le soir du 18 mars ? Selon toute vraisemblance, les capteurs ne sont pas en cause : le prototype Uber était équipé de la batterie habituelle de radars laser Lidar, parfaitement capables de distinguer des obstacles dans l’obscurité la plus complète, et ce à 360°. La malheureuse Elaine Herzberg a donc forcément été détectée par ces capteurs.

Mais la plus grande difficulté n’est pas tant dans la détection que dans l’identification. Les calculateurs des voitures autonomes sont abreuvés de gigaoctets de données. Dans cette masse, il faut être capable de faire le tri. Entre les obstacles fixes et les objets en mouvement. Entre les objets que l’on peut prendre le risque de percuter sans danger (oiseaux, feuilles mortes…) et ceux qu’il faut absolument éviter (piétons, cyclistes…). Les premiers sont qualifiés de « faux positifs » : des alertes émises par les capteurs un peu trop sensibles, que l’on peut négliger sans risque. On l’imagine aisément, le tri entre « faux » et « vrais » positifs est aussi compliqué que crucial…

Comment un Lidar perçoit son environnement.

Selon toute vraisemblance, le calculateur de la voiture Uber fautive n’a pas su identifier Elaine Herzberg, son vélo et ses sacs, comme un obstacle. Cet « objet » à la forme bizarre ne correspondant à rien de répertorié par l’intelligence artificielle, cette dernière a tout simplement estimé qu’il… n’était pas vraiment là ! En une fraction de seconde, l’IA a scellé le destin de la pauvre piétonne.

Cette défaillance a relancé le débat sur la pertinence même des voitures autonomes, y compris chez les experts du secteur automobile. Certains estiment qu’elle ne sera jamais parfaitement fiable, et que plutôt que de remplacer le conducteur, l’intelligence artificielle devrait plutôt le seconder, un peu à la manière de ce qui se passe dans l’aérien. L’humain resterait alors le vrai conducteur, et le seul décisionnaire. Dans le cas de l’accident fatal de Tempe, la voiture aurait ainsi pu signaler très en amont la présence d’Elaine Herzberg, laissant le temps au conducteur de freiner, ou de l’éviter. C’est la « conduite augmentée » (« augmented driving »), par opposition à la conduite autonome.

La Mercedes S 500 Intelligent Drive lors de son parcours Mannheim-Pforzheim.

En tous cas, cet accident, même s’il devait forcément finir par arriver, jette le doute sur la voiture autonome. Et si les spécialistes l’annoncent toujours pour 2020, voire 2022, il s’agira alors d’une automatisation dans certains scénarios bien particuliers (chaussées séparées, bonnes conditions météo, pas de piétons ni d’intersections…). La voiture vraiment autonome que nous vantent justement Uber, Waymo et autres Cruise Automation se fera encore longtemps désirer…

« La voiture vraiment autonome se fera encore longtemps désirer… »pas pour mois.Si je veux être conduit, j’apelle un taxi.

Ce n’est pas le premier accident mortel avec un voitur autonome, mais le deuxième.

Vous avez oubllié la Tesla autonome qui dans un accident en 2017,a tué son

conducteur/ passager…….

Aucune Tesla n’est autonome. C’est du SAE niveau 2, mais pas de l’autonomie.

Le niveau 5 est disponible sur la Model 3 pour 9000 $. Evidemment le conducteur est toujours sensé regarder la route les mains sur le volant pdt que la bagnole se conduit toute seule.

Donc ce n’est pas du niveau 5, qui est une totale autonomie sans aucune intervention du conducteur 🙂

Pour l’instant, personne ne fait mieux que le niveau 2 (« hands off »), Audi étant prêt pour le niveau 3 (« mind off ») sur la nouvelle A8 avec le traffic jam pilot. Mais la législation bannit pour l’instant ce niveau d’autonomie, sauf pour des prototypes nécessitant autorisation préalable.

Ping : Sécurité de la voiture autonome : le grand défi | Motorshift

Ping : L’autonomie de niveau 3 enfin sur des rails | Motorshift